Anfang des Jahres erklärte ein Nachrichtensprecher im US-Fernsehen, wie Amazon Alexa funktioniert, und aktivierte dabei zahlreiche Echos, die in den Wohnzimmern unweit der TV-Geräte standen und auf denen der persönliche Sprachassistent lief. Es fehlte nur noch der letzte Schritt, um tatsächlich unzählige Puppenhäuser zu bestellen. Hätte Alexa Stimmen unterscheiden können, wäre das nicht passiert. Das Konkurrenz-Produkt Google Home hat das gleiche Problem. Doch dort berichten einige Nutzer, ihnen sei in der zugehörigen App eine Option angezeigt worden, weitere Benutzerkonten zu aktivieren. Das würde dann vermutlich per Stimmerkennung funktionieren.

Google dementiert nicht

Ein weiteres Benutzerkonto tatsächlich hinzuzufügen, funktionierte aber noch nicht. Daraus lässt sich schließen, dass dieser Menüpunkt irrtümlich freigeschaltet wurde oder dass es sich lediglich um einen Test handelte, wieviele der Nutzer darauf reagieren. Das Unternehmen scheint sich aber definitiv darauf vorzubereiten, Google Home mit mehreren Benutzerkonten zu verbinden, antwortete auf eine Anfrage von Ars Technica aber bloß ausweichend: „We’ve seen the reports, and don’t have anything to share right now.“ Das ist weder eine Bestätigung noch ein Dementi.

Wer übrigens nicht möchte, dass die ganze Familie über den Google Home Zugriff auf die eigenen Daten erhält, muss derzeit noch einen zusätzlichen Account für die Familie anlegen. Das ist praktisch, wenn alle Zugriff auf den gemeinsamen Kalender oder auf die Steuerung des Smart Home erhalten sollen, verwehrt aber auch den Zugriff auf die eigenen persönlichen Daten.

Nicht in persönlichen Daten schnüffeln

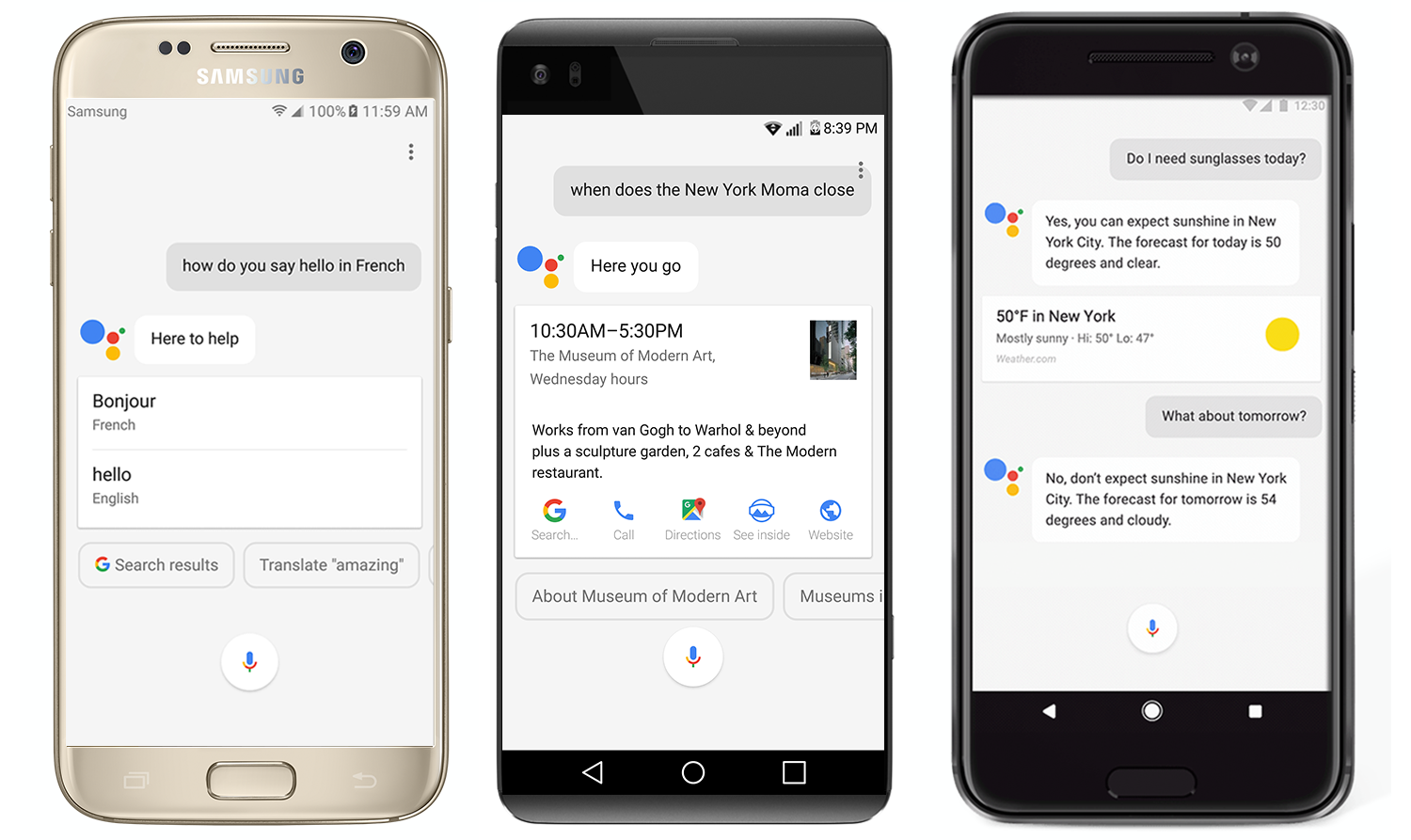

Um mehrere Benutzerkonten mit einem Google Home zu verbinden, wäre eine Stimmerkennung wie Trusted Voice auf dem Google Pixel oder einem anderen Smartphone mit Google Assistant die einzige denkbare Möglichkeit. Niemand möchte für einen Kontenwechsel vom Sofa aufstehen und zum Gerät laufen oder das Smartphone zur Hand nehmen.

Anhand der Stimme könnte Google Home dann unterscheiden, in welchen Kalender ein persönlicher Termin eingetragen wird. Wichtiger noch: Kein anderer könnte in den eigenen Daten wühlen, nachdem man selbst den Raum verlassen hat. Ein Problem bestände aber weiterhin: Anhand der Stimme könnte zwar unterschieden werden, wer einen Termin einträgt, aber nicht in welchen Kalender. Dafür bräuchte es mehr als nur eine Stimmerkennung, sondern ein tiefergehendes Verständnis von Sprache. (Okay, Google arbeitet daran. Das große Ziel bleibt, mit dem Computer so zu reden wie auf der Enterprise.)

Kurz und knackig, bitte

Andernfalls müssten die Nutzer immer längere Befehlsketten auswendig lernen: „Ok, Google. Wechsle von meinem persönlichen Account zum Familienkonto. Trage einen Termin in den Kalender ‚Aktivitäten der Kinder‘ ein. Mittwoch, 18 Uhr, Fußballtraining. Wechsle zurück zu meinem persönlichen Account“. Das will niemand sagen. Und Wortungetüme kann sich auch niemand merken. Über das Smartphone ließe sich das dann besser erledigen.

Eine verlässliche Spracherkennung würde aber nicht nur die Stimmen unterscheiden, sondern auch die Personen (hoffentlich) zweifelsfrei identifizieren – mit neuen Möglichkeiten beispielsweie beim Einkaufen und Bezahlen.

Bild: Twitter/@ow

Jetzt kommentieren!