Bei den Smartphone-Herstellern schien zuletzt der Megapixelwahn ausgebrochen zu sein. Mit 64 Megapixeln löst alleine schon ein Smartphone der unteren Mittelklasse auf, wie das Motorola Moto G30. Die Spitze wie Samsung im Galaxy S21 Ultra oder Xiaomi im Mi 11 bewirbt ganze 108 Megapixel. Als fertige Datei kommt später trotzdem ein viel kleineres Bild mit nur noch 12 oder 16 MP heraus. Möglich macht das eine Technik namens Pixel Binning.

Aus 108 Megapixeln werden 12, aus 64 werden 16

Pixel Binning rechnet mehrere benachbarte Pixel zu einem zusammen. Motorola macht im Moto G30 (hier unser Testbericht) aus 64 Megapixeln 16, indem es 4 Pixel zu einem verrechnet. Samsung verschmilzt in einer 108-MP-Kamera sogar 9 Pixel zu 1. Das Ergebnis ist ein 12-Megapixel-Bild.

Und hier wird der eine oder andere hellhörig: Denn viele Kamera-Sensoren in Smartphones setzen ohnehin nur auf 12 Megapixel, auch ohne Pixel Binning. Darunter sind etwa das Galaxy S21, die kleine Schwester des S21 Ultra, aber auch Apple in der iPhone-12-Serie. Die einzelnen Pixel dieser Geräte sind für gewöhnlich größer. Was ist also besser? Viele kleine Megapixel oder wenige große?

Viele Bildpunkte auf kleinstem Raum

Die Antwort ist: Es kommt darauf an. Der Megapixel-Boom führt auf Smartphones zu Problemen: Weil die Sensoren im Vergleich zu Spiegelreflex- und Systemkameras klein sind und aus Platzproblemen nicht deutlich größer werden können, quetschen die Ingenieure immer mehr Bildpunkte auf engsten Raum.

Schärfe und mehr Details sind die Argumente dafür. Ebenso ein besserer Digitalzoom. Mehr Bildpunkte ermöglichen mehr Details auch für weit entfernte Motive, die ihr dann ohne (massiven) Qualitätsverlust vergrößern könnt.

Tagsüber, bei strahlendem Sonnenschein, geht die Rechnung auf: Mehr Megapixel = mehr Details und bessere Zooms. Einzelne Hersteller verzichten bei guten Lichtverhältnissen sogar auf das Pixel Binning und brennen die vollen 64 oder 108 Megapixel aufs Bild.

Zum Problem werden viele Megapixel dafür bei diesiger Sicht, trüber Bewölkung, Dämmerlicht oder in der Nacht. Da die Pixelgröße schrumpft, nimmt jeder Bildpunkt weniger Licht auf und ist rauschanfälliger. So treten unschöne Artefakte und Kontrastarmut paarweise auf.

Im Prinzip zumindest, denn Pixel Binning soll dem entgegen wirken. Indem es verschiedene Fotodioden und Pixel zusammenfasst, soll so die Licht- und Farbempfindlichkeit wieder steigen.

Keine Ahnung? Frag die Nachbarn!

Die Idee: Mehr kleine Pixel, wo sonst nur ein großes wäre, können verlässlichere Informationen liefern und somit den Nachteil zu kleiner Pixel ausgleichen.

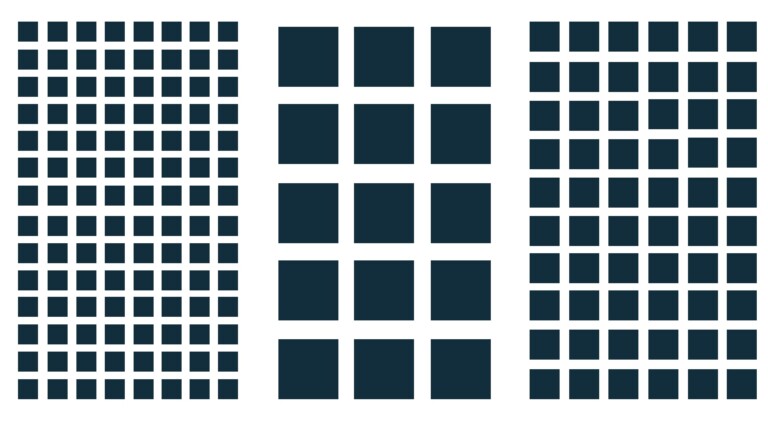

Grundsätzlich gibt es zwei Methoden, Bildinformationen zu kombinieren. Zu einem ein Sensor-basiertes Binning, das Quadrate von 2×2 oder 3×3 Bildpunkten zusammenrechnet. Zum anderen das digitale Binning, das für jeden Pixel weitere benachbarte Informationen heranzieht.

Neu ist das Verfahren bis hierhin nicht – beschrieben ist es erstmals 1993. In der Praxis brillierten die legendären Nokia-Smartphones der Lumia-Familie Anfang der 2010er-Jahre mit effektivem Pixel Binning. Und garantierten bei widrigsten Lichtverhältnissen kontrastreiche Bilder und Videos – wenngleich diese nicht im RAW vorliegen können, da das Smartphone bereits massiv in die Fotoberechnung eingreift. Ein Nachteil der Technik.

Die »Magie« hinter der Technik alter Nokia-Smartphones ist einfach erklärt. Auslöser gedrückt, Pixel verrechnet – vermindertes Bildrauschen. Ob nun direkt auf dem Sensor geschehen oder in der digitalen Pixel-Zusammenfassung im Nachgang, war egal. Danach verschwand das Pixel Binning für viele Smartphone-Generationen erst einmal wieder in der Versenkung.

Was ist neu? Adaptive Pixel Binning

Die erneute Prominenz der Bildpunkte-Verrechnung kommt allerdings nicht überraschend. Hardware- und Software-Ingenieure werkelten jahrelang an Optimierungen. Sprechen wir heute von dieser Technologie, ist das Adaptive Pixel Binning gemeint.

Voraussetzung für die Integration waren leistungsstärkere Smartphones. Denn längst ziehen Hard- und Software nicht nur die Informationen zusammen und berechnen daraus einen Durchschnitt. Es ist komplexer.

Ihr zückt bei widrigen Lichtbedingungen euer Smartphone. Während ihr noch die Vorschau betrachtet, analysiert die Foto-App in Echtzeit, ob es zum Pixel Binning greifen müsste. Entscheidet es sich dafür und drückt ihr den Auslöser, kommt eine Prozesskette in Gang.

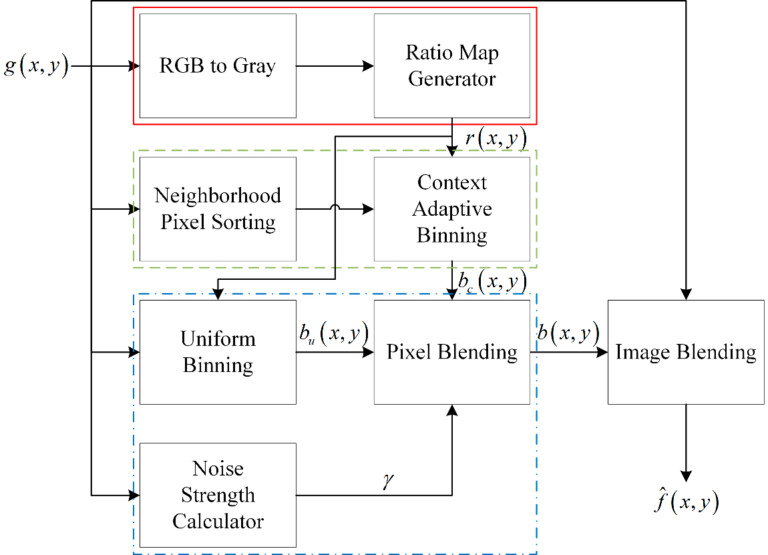

Zunächst dupliziert die Software das Foto viermal. Das erste Abbild konvertiert ein Algorithmus vom Farbbild in eine Graustufenversion (oben im roten Rahmen dargestellt). Darin enthalten sind nur die Helligkeitsinformationen. Sie sind für die subjektiv empfundene Bildschärfe unerlässlich. Die Trennung der Helligkeits- von den Farbinformationen macht sich nicht nur das Pixel Binning zunutze.

Die Farbunterabtastung, die wir euch in diesem Trendblog-Artikel näher bringen, profitiert ebenfalls davon und kommt am Ende des Binning-Vorgangs zum Einsatz.

Das zweite Abbild (oben im grünen Rahmen) eures Fotos dient der Sortierung der benachbarten Pixel in 2×2- oder 3×3-Rastern. Wie viele Bildpunkte jeweils zusammengefasst sind, ist eine Abwägung zwischen der allgemeinen Bildqualität und Helligkeit einerseits und der geringeren Auflösung andererseits.

Kombinieren, sortieren und rendern

Ein Beispiel: Samsungs Galaxy S20 Ultra und das Xiaomi Mi Note 10 Pro teilen sich den gleichen Kamerasensor mit 108 MP. Das Xiaomi nutzt ein 2×2-Binning und kommt effektiv auf 27 Megapixel. Das Samsung-Modell nutzt 3×3-Raster und landet bei 12 MP.

Spezial-Prozessoren für maschinelles Lernen ermitteln, welche farblichen Bildpunkte zusammenzufassen sind und sortieren sie noch einmal. Das bringt diese Informationen in einen Kontext und speichert das Zwischenbild.

Die Foto-Duplikate drei und vier landen in einem dritten Schritt, der im Schema oben blau hinterlegt ist. Statt Helligkeitswerten und Farbinformationen filtert das Telefon die Rauschintensität einzelner Pixel und ganzer Blöcke und mindert sie ab.

In einem letzten Schritt blendet der Algorithmus die vier Duplikate übereinander und rendert das finale Bild heraus. Das Ergebnis sollte idealerweise eine rauscharme, detaillierte Datei sein.

Wie sich Pixel Binning auf die Fotoqualität auswirkt

Je nachdem, wie die einzelnen Schritte berechnet sind, fallen die Fotos unterschiedlich aus:

In einem 2015 veröffentlichten Aufsatz zeigen IT-Experten, wie unterschiedlich Pixel Binning aufs Resultat Einfluss ausübt. Oben links seht ihr das Referenzfoto (ISO 3200, EV +1).

Oben mittig das unterbelichtete Foto (ISO 800, EV -1), das zunächst auf den Smartphone-Sensor trifft. Das ordinäre Pixel Binning mit 2×2-Zusammenfassung produziert daraus das Ergebnis oben rechts. Es ist ruhiger, aber weniger hoch aufgelöst.

Das Foto unten links ergänzt das Foto und um einen weiteren Algorithmus, der die Pixel-Zahl erhöht. Unten mittig das digitale Binning ohne Quardrat-Zusammenfassung.

Unten rechts schließlich als Ergebnis das allumfassenden Adaptive Pixel Binning. Die Kontraste sind gut, die Farben satt, die Bildschärfe hoch.

Smartphones mit Pixel Binning oder ohne: Was ist besser?

Samsung, Apple, Oppo oder Huawei präsentieren gerne brillante Nachtaufnahmen ihrer neuen Smartphone-Flaggschiffe. Im Alltag liefern diese Spitzenmodelle in den meisten Problemsituationen ordentliche Fotos – auf unterschiedliche Art.

So kommt in fast allen modernen Smartphones mit oder ohne Pixel Binning heute auch ein Nachtmodus zum Einsatz. Der basiert auf HDR und erzeugt in meist wenigen Augenblicken eine Vielzahl von Einzelbildern eines Motivs, die clevere Algorithmen mit Hilfe künstlicher Intelligenz anschließend zusammenrechnet. Das Ergebnis ist nicht selten ein fast taghelles Bild mit nur noch wenigen dunklen Bereichen.

Aber was funktioniert nun besser? Kamera-Systeme mit Pixel Binning, die 108 MP große Bilder zu 12-MP-Bilder zusammenrechnen oder 12-MP-Systeme ohne Pixel Binning?

Mein Kollege Jürgen Vielmeier ließ das Samsung Galaxy S21 Ultra 5G gegen das iPhone 12 Pro Max antreten, das kein Pixel Binning verwendet. Lagen beide Smartphones bei der Bildqualität tagsüber in etwa gleichauf, rauschen die Bilder des S21 Ultra nachts tatsächlich deutlich mehr.

Weniger ist mehr? Manchmal ja

Vor allem an den Rändern machten sich beim S21 Ultra unschöne Artefakte breit, und das sowohl bei Bildern mit HDR-Nachtmodus als auch ohne. Weil beim Nachtmodus viel von Künstlicher Intelligenz abhängt, lässt sich hier nicht genau klären, was der Auslöser für die unterschiedliche Bildqualität ist. Weil Apples „normaler“ Sensor allerdings auch bei Bildern ohne Nachtsicht weniger rauscht, müssen wir festhalten, dass diese Runde an die Kamera ohne Adaptives Pixel Binning geht.

| Vorteile von Pixel Binning | Nachteile von Pixel Binning |

|---|---|

| Schafft größere, virtuelle Pixel | Unterstützt kein RAW |

| Harmonischerer Gesamteindruck | Nachtbilder rauschen tatsächlich mehr |

| Tagsüber höhere Auflösungen möglich | Nachtbilder sind etwas dunkler |

| Digitalzoom möglich |

Böse gesprochen: Sind die Pixel zu klein, um verlässliche Farb- und Helligkeitsinformationen zu ermitteln, hilft es wenig, wenn sie ihre Nachbarn fragen, die es auch nicht besser wissen. Das Ergebnis ist dann nur noch mehr Unsicherheit.

Ist das also schon der Abgesang auf Adaptive Pixel Binning? Mitnichten, auch Apple hat im neuen iPhone 14 Pro (Link führt zum Test) diese Technologie verbaut und rechnet eine 48-Mp-Aufnahme auf 12 MP herunter. Getestet haben wir die Kamera des iPhone 14 Pro in einem weiteren Beitrag.

Pixel Binning hat noch Luft nach oben

Klare Antwort: nein. Schon jetzt macht sich die Technik bei guten Lichtverhältnissen und bei Dämmerung bezahlt. Nachts sind die Ergebnisse noch ausbaufähig. Adaptive Pixel Binning ist bei Smartphone-Kameras allerdings den Kinderschuhen noch nicht ganz entwachsen. Bessere Algorithmen, lichtstärkere Objektive, größere Sensoren und Pixel – das alles sind noch Stellschrauben, die die Hersteller haben, um die Technik in Zukunft weiter zu verbessern.

Übrigens, Pixel Binning oder nicht: Mein Kollege Kay Nordenbrock erklärt euch in einem weiteren Beitrag, was eine gute Smartphone-Kamera sonst noch ausmacht.

(Aufmacher: Pexels.com / William Fortunato)

Pixel Binning sollte sinnvoll eingesetzt werden und nicht um Marketing-Gags zu ermöglíchen wie aktuell bspw. bei Samsung. Man kann sich grob als Daumenregel merken: Alles unter 1µm Pixelgröße ist reiner Marketing-Gag und kann nicht sinnvoll in der Praxis eingesetzt werden. Sensoren wie z.B. die HM- und HMX-Serie von Samsung, die Pixelgrößen zwischen 0,64µm und 0,8µm besitzen, sind demnach reine Marketing-Gags. Deren 108 Megapixel können nicht in qualitativen Mehrwert umgesetzt werden. Und genau aus diesem Grund verstecken die Hersteller den 108MP Modus irgendwo in Untermenüs und nutzen standardmäßig nur die 12MP mittels Pixel-Binning. Ein Samsung HM2-Sensor hätte daher genauso gut direkt als 12MP Sensor gebaut werden können, weil die 108MP eh nicht sinnvoll nutzbar sind. Oder man hätte ihn als 24MP Sensor bauen können und per 4:1 Pixel Binning 6MP bei sehr dunklen Szenarien, weil die 12MP in der Nacht immer noch zu Rauschen oder verwackeln neigen.

Eigentlich ist PixelBinning eine sinnvolle Technologie. Nutzbar sind die aktuellen 48MP und mehr Modi bei aktuellen Smartphone-Sensoren aber nicht. In der aktuellen Form kann man sich diese Technik daher im Grunde sparen und direkt Sensoren mit 12 Megapixeln bauen.

Hi danke für diesen Ausführlichen Bericht und das verständliche erklären. Danke Danke habe seit 1-2 Wochen gesucht danach.

Habe ein ZTE Blade V40 pro gekauft mit 64mp und glaube die Hauptkamera hat 48mp, jetzt weiß ich warum ich bei der App bis nur Max 16mp einstellen kann.

Ob das alles sinnvoll ist werde ich testen, aber ehrlich gesagt warum können die Hersteller dies nicht klar kommunizieren. So vermeidet man ärger und Probleme.

Habe schon gelesen das welche die Handys zurück geschickt haben da sie nur 16mp in der App einstellen können und sich so betrogen fühlten.

Ehrlich gesagt war ich auch schon kurz davor das Handy anzustoßen zu Mutti😅😂.

Also so danke schön nochmals für die Info.

Jetzt die Frage, woher weiß ich ob der Hersteller dieses Verfahren benutzt?